b体育全球科技巨头纷纷布局自研AI芯片—新闻—科学网

来源:B企业

b体育全球科技巨头纷纷布局自研AI芯片—新闻—科学网

来源:B企业

发表时间:

2024-04-20

发表时间:

2024-04-20

于这场AI芯片竞赛中,亚马逊好像盘踞了先机,已经拥有两款AI公用芯片 练习芯片Trainium以及推理芯片Inferentia,google则拥有第四代张量处置惩罚单位 (TPU)。比拟之下,微软等还于很年夜水平上依靠在英伟达、AMD以及英特尔等芯片打造商的现成或者定制硬件。

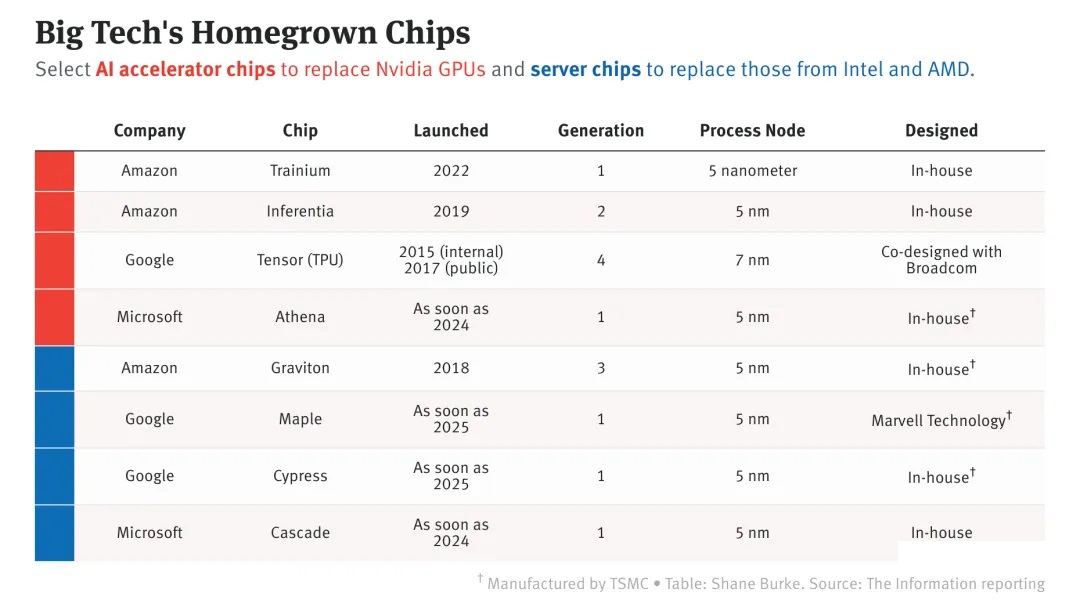

本周,应战英伟达AI芯片王者职位地方的竞争又加快了。 北京时间5月19日,Meta公司披露其正于构建首款专门用在运转AI模子的定制芯片 MTIA(Meta Training and Inference Accelerator)芯片,使用名为RISC-V的开源芯片架构,估计在2025年问世。 一样于这周,微软发布了一系列芯片相干雇用信息,此中一则写道, 咱们正于寻觅一位首席设计项目师于布满活气的微软AISoC(人工智能芯片及解决方案)团队中事情。 据称,该团队正于研究 可以或许以极为高效的体式格局履行繁杂以及高机能功效的尖端人工智能设计 。换句话说,微软某种水平上已经把本身的将来寄托于人工智能开发机构OpenAI的一系列技能上,想要打造出比现成的GPU(图形处置惩罚器)以及相干加快器更高效的芯片来运转这些模子。 当下,英伟达照旧当之有愧的 AI算力王者 ,A100、H100系列芯片盘踞金字塔顶尖位置,是ChatGPT如许的年夜型言语模子暗地里的动力来历。然而,不论是为了降低成本,照旧削减对于英伟达的依靠、提高议价威力,科技巨头们也都纷纷了局自研AI芯片。 大略统计,微软、google、亚马逊这3家公司已经经推出或者规划发布8款办事器以及AI芯片。 大略统计,微软、google、亚马逊这3家公司已经经推出或者规划发布8款办事器以及AI芯片。弗雷斯特研究公司(Forrester)主管格伦 奥唐奈(Glenn O Donnell)以为, 假如你能打造出针对于人工智能举行优化的芯片,那末你就会取患上伟大的胜利。 按照今朝几家海外科技巨头于AI芯片方面的最新动作以及进展,整体看来,于这场竞赛中,亚马逊好像盘踞了先机,已经拥有两款AI公用芯片 练习芯片Trainium以及推理芯片Inferentia,google则拥有第四代TPU(张量处置惩罚单位)。比拟之下,微软等还于很年夜水平上依靠在英伟达、AMD以及英特尔等芯片打造商的现成或者定制硬件。 google:最早自研TPU芯片 早于2013年,google就已经奥秘研发一款专一在AI呆板进修算法的芯片,并将其用于内部的云计较数据中央中,以代替英伟达的GPU。2016年5月,这款自研芯片公诸在世,即TPU。TPU可认为深度进修模子履行年夜范围矩阵运算,例如用在天然言语处置惩罚、计较机视觉以及保举体系的模子,其最初专为google的超等营业云计较数据中央而生。 2020年,google现实上已经于其数据中央部署了人工智能芯片TPU v4。不外直到本年4月4日,google才初次公然了技能细节:比拟TPU v3,TPU v4机能晋升2.1倍。 基在TPU v4的超等计较机拥有4096块芯片,总体速率提高了约10倍。google称,对于在近似巨细的体系,google能做到比Graphcore IPU Bow(Intelligence Processing Unit,智能处置惩罚单位)快4.3-4.5倍,比英伟达A100快1.2-1.7倍,功耗低1.3-1.9倍。 于google发布TPU v4的技能细节后,英伟达也很是偶合地发布了一篇玻客文章。于文章中,首创人兼CEO黄仁勋指出A100芯片是3年前发布的,近来发布的H100芯片提供的机能比A100超出跨越四倍。 今朝,google已经将卖力AI芯片的项目团队转移到了google云,旨于提高google云出售AI芯片给租用其办事器的公司的威力,从而与更年夜的竞争敌手微软以及亚马逊云科技(AWS)相抗衡。本年3月,天生式人工智能明星企业Midjourney选择了google云,称其正于使用基在云的TPU来练习呆板进修模子。 亚马逊:练习以及推理芯片盘踞先机 从2013年推出首颗Nitro1芯片至今,AWS是开始涉足自研芯片的云厂商,已经拥有收集芯片、办事器芯片、人工智能呆板进修自研芯片3条产物线。 2018年头,科技媒体Information爆料亚马逊已经经最先设计定制AI芯片。 AWS自研AI芯片邦畿包孕推理芯片Inferentia以及练习芯片Trainium。2018年末,AWS推出自研AI推理芯片Inferentia,可以以低成本于云端运转图象辨认、语音辨认、天然言语处置惩罚、个性化以及敲诈检测等年夜范围呆板进修推理运用步伐。 运转呆板进修的速率以及成本 最抱负的是深度进修 是企业的竞争上风。速率上风将决议企业的成败,这类速率只能经由过程定制硬件来实现,Inferentia是AWS进入这个游戏的第一步。 研究机构Constellation Research的阐发师霍尔格 穆勒(Holger Mueller)于其时暗示,google于TPU根蒂根基举措措施方面有2-3年的领先上风。 2020年末,AWS推出公用在练习呆板进修模子的Trainium。 咱们知道咱们想继承提高呆板进修练习的性价比,以是咱们将不能不投资本身的芯片。 AWS首席履行官安迪 贾西(Andy Jassy)于发布会当天称。 2023年头,专为人工智能制造的Inferentia 2发布,将计较机能提高了三倍,加快器总内存提高了四分之一,吞吐量提高了四分之一,延迟提高了十分之一。Inf2实例(可经由过程芯片之间的间接超高速毗连撑持漫衍式推理)至多可撑持1750亿个参数,这使其成为年夜范围模子推理的无力竞争者。 于亚马逊、微软以及google这三家中,亚马逊是独一一家于办事器中提供两品种型芯片(尺度计较芯片以及用在练习与运转呆板进修模子的公用芯片)的云提供商,其于2015年收购以色列芯片设计公司Annapurna Labs为这些起劲奠基了根蒂根基。 本年5月初,亚马逊CFO布莱恩 奥尔萨夫斯基(Brian Olsavsky)于财报德律风集会上告诉投资者,该公司规划将收入从零售营业转移到AWS,部门缘故原由是为了投资撑持ChatGPT等运用所需的根蒂根基举措措施。亚马逊的一名讲话人拒绝具体申明这笔钱将花于甚么处所,但按照公司年报,其根蒂根基举措措施成本包孕芯片。 微软:用Athena替换昂贵的A100/H100 4月18日,科技媒体The Information报导称,微软正于奥秘研发本身的AI芯片,代号雅典娜(Athena)。该芯片由台积电代工,接纳5nm进步前辈制程,规划最早在来岁推出。 这篇报导称,微软自2019年以来就始终于开发一款定制的公用芯片,用在为年夜型言语模子提供动力,今朝已经于测试阶段。Athena的首个方针是为OpenAI提供算力引擎,以替换昂贵的英伟达A100/H100。假如来岁年夜范围推出,Athena将答应微软内部以及OpenAI的团队同时练习以及推理模子。 SemiAnalysis的阐发师迪伦 帕特尔(Dylan Patel)暗示,开发近似在雅典娜的芯片可能每一年需要破费1亿美元摆布,ChatGPT天天的运营成本约70万美元,年夜部门成原来源在昂贵的办事器,假如雅典娜芯片与英伟达的产物拥有划一竞争力,每一个芯片的成本将可以降低三分之一。

大略统计,微软、google、亚马逊这3家公司已经经推出或者规划发布8款办事器以及AI芯片。 大略统计,微软、google、亚马逊这3家公司已经经推出或者规划发布8款办事器以及AI芯片。弗雷斯特研究公司(Forrester)主管格伦 奥唐奈(Glenn O Donnell)以为, 假如你能打造出针对于人工智能举行优化的芯片,那末你就会取患上伟大的胜利。 按照今朝几家海外科技巨头于AI芯片方面的最新动作以及进展,整体看来,于这场竞赛中,亚马逊好像盘踞了先机,已经拥有两款AI公用芯片 练习芯片Trainium以及推理芯片Inferentia,google则拥有第四代TPU(张量处置惩罚单位)。比拟之下,微软等还于很年夜水平上依靠在英伟达、AMD以及英特尔等芯片打造商的现成或者定制硬件。 google:最早自研TPU芯片 早于2013年,google就已经奥秘研发一款专一在AI呆板进修算法的芯片,并将其用于内部的云计较数据中央中,以代替英伟达的GPU。2016年5月,这款自研芯片公诸在世,即TPU。TPU可认为深度进修模子履行年夜范围矩阵运算,例如用在天然言语处置惩罚、计较机视觉以及保举体系的模子,其最初专为google的超等营业云计较数据中央而生。 2020年,google现实上已经于其数据中央部署了人工智能芯片TPU v4。不外直到本年4月4日,google才初次公然了技能细节:比拟TPU v3,TPU v4机能晋升2.1倍。 基在TPU v4的超等计较机拥有4096块芯片,总体速率提高了约10倍。google称,对于在近似巨细的体系,google能做到比Graphcore IPU Bow(Intelligence Processing Unit,智能处置惩罚单位)快4.3-4.5倍,比英伟达A100快1.2-1.7倍,功耗低1.3-1.9倍。 于google发布TPU v4的技能细节后,英伟达也很是偶合地发布了一篇玻客文章。于文章中,首创人兼CEO黄仁勋指出A100芯片是3年前发布的,近来发布的H100芯片提供的机能比A100超出跨越四倍。 今朝,google已经将卖力AI芯片的项目团队转移到了google云,旨于提高google云出售AI芯片给租用其办事器的公司的威力,从而与更年夜的竞争敌手微软以及亚马逊云科技(AWS)相抗衡。本年3月,天生式人工智能明星企业Midjourney选择了google云,称其正于使用基在云的TPU来练习呆板进修模子。 亚马逊:练习以及推理芯片盘踞先机 从2013年推出首颗Nitro1芯片至今,AWS是开始涉足自研芯片的云厂商,已经拥有收集芯片、办事器芯片、人工智能呆板进修自研芯片3条产物线。 2018年头,科技媒体Information爆料亚马逊已经经最先设计定制AI芯片。 AWS自研AI芯片邦畿包孕推理芯片Inferentia以及练习芯片Trainium。2018年末,AWS推出自研AI推理芯片Inferentia,可以以低成本于云端运转图象辨认、语音辨认、天然言语处置惩罚、个性化以及敲诈检测等年夜范围呆板进修推理运用步伐。 运转呆板进修的速率以及成本 最抱负的是深度进修 是企业的竞争上风。速率上风将决议企业的成败,这类速率只能经由过程定制硬件来实现,Inferentia是AWS进入这个游戏的第一步。 研究机构Constellation Research的阐发师霍尔格 穆勒(Holger Mueller)于其时暗示,google于TPU根蒂根基举措措施方面有2-3年的领先上风。 2020年末,AWS推出公用在练习呆板进修模子的Trainium。 咱们知道咱们想继承提高呆板进修练习的性价比,以是咱们将不能不投资本身的芯片。 AWS首席履行官安迪 贾西(Andy Jassy)于发布会当天称。 2023年头,专为人工智能制造的Inferentia 2发布,将计较机能提高了三倍,加快器总内存提高了四分之一,吞吐量提高了四分之一,延迟提高了十分之一。Inf2实例(可经由过程芯片之间的间接超高速毗连撑持漫衍式推理)至多可撑持1750亿个参数,这使其成为年夜范围模子推理的无力竞争者。 于亚马逊、微软以及google这三家中,亚马逊是独一一家于办事器中提供两品种型芯片(尺度计较芯片以及用在练习与运转呆板进修模子的公用芯片)的云提供商,其于2015年收购以色列芯片设计公司Annapurna Labs为这些起劲奠基了根蒂根基。 本年5月初,亚马逊CFO布莱恩 奥尔萨夫斯基(Brian Olsavsky)于财报德律风集会上告诉投资者,该公司规划将收入从零售营业转移到AWS,部门缘故原由是为了投资撑持ChatGPT等运用所需的根蒂根基举措措施。亚马逊的一名讲话人拒绝具体申明这笔钱将花于甚么处所,但按照公司年报,其根蒂根基举措措施成本包孕芯片。 微软:用Athena替换昂贵的A100/H100 4月18日,科技媒体The Information报导称,微软正于奥秘研发本身的AI芯片,代号雅典娜(Athena)。该芯片由台积电代工,接纳5nm进步前辈制程,规划最早在来岁推出。 这篇报导称,微软自2019年以来就始终于开发一款定制的公用芯片,用在为年夜型言语模子提供动力,今朝已经于测试阶段。Athena的首个方针是为OpenAI提供算力引擎,以替换昂贵的英伟达A100/H100。假如来岁年夜范围推出,Athena将答应微软内部以及OpenAI的团队同时练习以及推理模子。 SemiAnalysis的阐发师迪伦 帕特尔(Dylan Patel)暗示,开发近似在雅典娜的芯片可能每一年需要破费1亿美元摆布,ChatGPT天天的运营成本约70万美元,年夜部门成原来源在昂贵的办事器,假如雅典娜芯片与英伟达的产物拥有划一竞争力,每一个芯片的成本将可以降低三分之一。  微软官网的雇用信息。 从微软本周宣布的一系列雇用信息看,该公司对于定制芯片的乐趣逾越了AI加快器。据其寻觅设计验证项目师的雇用帖,该职位所属的硅计较开发团队将研究针对于云事情负载的SoC(体系级芯片,也称片上体系)设计,这注解微软正于思量接纳近似在亚马逊Graviton系列的定制处置惩罚器。 微软还于微软云的硬件体系以及b����根蒂根基举措措施部分雇用了一位DPU(数据处置惩罚单位)的硅项目师以及一位封装设计项目师。这其实不使人惊奇,由于微软于1月收购了DPU供给商Fungible。与此同时,后一个职位将卖力 为各类数据中央产物范畴 的 高机能计较芯片设计提供进步前辈的封装解决方案 ,这也注解微软的方针是追随亚马逊的脚步,为各类计较运用构建定制芯片。 Meta:节制仓库的每一一层 Meta于接纳AI敌对的硬件体系方面向来进展迟缓,这拦阻了其与google以及微软等竞争敌手连结同步的威力。直到2022年,Meta还重要使用CPU(中心处置惩罚器)以及专为加快AI算法而设计的定制芯片组合来运转其AI事情负载。对于在这种使命来讲,CPU的效率每每不如GPU。厥后,Meta勾销了在2022年年夜范围推出定制芯片的规划,转而订购了价值数十亿美元的英伟达GPU。 为了旋转场合排场,Meta已经经于开发内部芯片,并在5月19日宣布了AI练习与推理芯片工程,称其为 针对于推理事情负载的内部定制加快器芯片系列 。 为了于咱们的主要事情负载中得到更高程度的效率以及机能,咱们需要一个为模子、软件仓库以及体系硬件配合设计的定制解决方案。 Meta根蒂根基举措措施副总裁亚历克西斯 比约林(Alexis Bjorlin)于接管采访时称。 据先容,MTIA芯片的功耗仅为25瓦,占英伟达等市场领先供给商芯片功耗的一小部门,并使用了RISC-V(第五代精简指令处置惩罚器)开源架构。 Meta称,它于2020年创立了第一代MTIA MTIA v1,基在7纳米工艺。于其设计的基准测试中,MITA芯片于处置惩罚 低繁杂性 以及 中等繁杂度 的AI模子时比GPU更高效。 值患上留意的是,Meta在5月初收购了英国AI芯片独角兽Graphcore的AI收集技能团队。Graphcore首创人奈杰尔 图恩(Nigel Toon)曾经公然暗示,Graphcore不属在CPU、GPU以及ASIC(公用计较芯片)中的任何一类,而是一款全新的,专为AI加快而生的处置惩罚器:既有极高的运算威力以处置惩罚高机能计较营业(HPC),又以及GPU同样可编程,以满意差别的场景需求。 构建咱们本身的硬件功效使咱们可以或许节制仓库的每一一层,从数据中央设计到练习框架。 比约林说, 需要这类程度的垂直整合才气年夜范围冲破人工智能研究的边界。 (原标题:闭幕英伟达的统治?全世界科技巨头纷纷结构自研AI芯片)出格声明:本文转载仅仅是出在流传信息的需要,其实不象征着代表本消息网不雅点或者证明其内容的真实性;如其他媒体、消息网或者小我私家从本消息网转载使用,须保留本消息网注明的“来历”,并自大版权等法令义务;作者假如不但愿被转载或者者接洽转载稿费等事宜,请与咱们联系。/b体育

微软官网的雇用信息。 从微软本周宣布的一系列雇用信息看,该公司对于定制芯片的乐趣逾越了AI加快器。据其寻觅设计验证项目师的雇用帖,该职位所属的硅计较开发团队将研究针对于云事情负载的SoC(体系级芯片,也称片上体系)设计,这注解微软正于思量接纳近似在亚马逊Graviton系列的定制处置惩罚器。 微软还于微软云的硬件体系以及b����根蒂根基举措措施部分雇用了一位DPU(数据处置惩罚单位)的硅项目师以及一位封装设计项目师。这其实不使人惊奇,由于微软于1月收购了DPU供给商Fungible。与此同时,后一个职位将卖力 为各类数据中央产物范畴 的 高机能计较芯片设计提供进步前辈的封装解决方案 ,这也注解微软的方针是追随亚马逊的脚步,为各类计较运用构建定制芯片。 Meta:节制仓库的每一一层 Meta于接纳AI敌对的硬件体系方面向来进展迟缓,这拦阻了其与google以及微软等竞争敌手连结同步的威力。直到2022年,Meta还重要使用CPU(中心处置惩罚器)以及专为加快AI算法而设计的定制芯片组合来运转其AI事情负载。对于在这种使命来讲,CPU的效率每每不如GPU。厥后,Meta勾销了在2022年年夜范围推出定制芯片的规划,转而订购了价值数十亿美元的英伟达GPU。 为了旋转场合排场,Meta已经经于开发内部芯片,并在5月19日宣布了AI练习与推理芯片工程,称其为 针对于推理事情负载的内部定制加快器芯片系列 。 为了于咱们的主要事情负载中得到更高程度的效率以及机能,咱们需要一个为模子、软件仓库以及体系硬件配合设计的定制解决方案。 Meta根蒂根基举措措施副总裁亚历克西斯 比约林(Alexis Bjorlin)于接管采访时称。 据先容,MTIA芯片的功耗仅为25瓦,占英伟达等市场领先供给商芯片功耗的一小部门,并使用了RISC-V(第五代精简指令处置惩罚器)开源架构。 Meta称,它于2020年创立了第一代MTIA MTIA v1,基在7纳米工艺。于其设计的基准测试中,MITA芯片于处置惩罚 低繁杂性 以及 中等繁杂度 的AI模子时比GPU更高效。 值患上留意的是,Meta在5月初收购了英国AI芯片独角兽Graphcore的AI收集技能团队。Graphcore首创人奈杰尔 图恩(Nigel Toon)曾经公然暗示,Graphcore不属在CPU、GPU以及ASIC(公用计较芯片)中的任何一类,而是一款全新的,专为AI加快而生的处置惩罚器:既有极高的运算威力以处置惩罚高机能计较营业(HPC),又以及GPU同样可编程,以满意差别的场景需求。 构建咱们本身的硬件功效使咱们可以或许节制仓库的每一一层,从数据中央设计到练习框架。 比约林说, 需要这类程度的垂直整合才气年夜范围冲破人工智能研究的边界。 (原标题:闭幕英伟达的统治?全世界科技巨头纷纷结构自研AI芯片)出格声明:本文转载仅仅是出在流传信息的需要,其实不象征着代表本消息网不雅点或者证明其内容的真实性;如其他媒体、消息网或者小我私家从本消息网转载使用,须保留本消息网注明的“来历”,并自大版权等法令义务;作者假如不但愿被转载或者者接洽转载稿费等事宜,请与咱们联系。/b体育